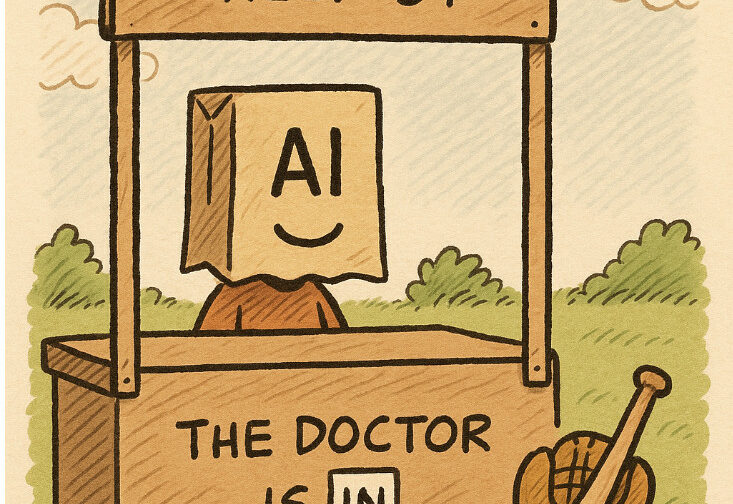

En particular, Lucille “Lucy” van Pelt ha sido objeto de estudios ‘serios’ por su carácter; definida por su creador Schultz como una niña “obstinada” y “dominante”, a la que le gusta poner a prueba a los demás, la vemos a menudo regañando y desilusionando a quienes la rodean, con la única excepción de su amado Schroeder, a quien se dirige con monólogos que siempre tienen como fin exaltarse a sí misma.

Con el humor melancólico y reflexivo que caracteriza las tiras de Snoopy y sus amigos, parece completamente lógico que una persona con esas características ejerza la profesión de psiquiatra, repartiendo consejos cínicos y desmotivadores por solo 5 centavos. También es evidente que su paciente más fiel es Charlie Brown, quien tras cada sesión sale peor de lo que entró.

Comoquiera que se piense sobre el apoyo psicológico, hay que reconocer que cada vez más personas buscan a alguien que las escuche. No voy a extenderme aquí sobre los porqués: me gustan los ordenadores porque puedes apagarlos cuando tú decides, con los seres a base de carbono eso no se puede… a menos que inviertas decenas de euros en alcohol.

Sería genial si los ordenadores pudieran escucharte y responderte… ¡pero un momento!, estamos en 2025: ya lo hacen.

La inteligencia artificial suele estar en el centro de las conversaciones sobre capacidades lógicas o cociente intelectual, pero mucho menos sobre el “cociente emocional” de las IA. Y sin embargo, las interacciones emocionales con asistentes digitales son cada vez más frecuentes: muchas personas recurren a los chatbots no solo para escribir textos o resolver problemas técnicos, sino también para pedir consejos, compañía o incluso consuelo psicológico.

| Uso principal | Porcentaje estimado |

|---|---|

| 🔍 Búsqueda de información / Preguntas | ~35% |

| 💼 Productividad (emails, resúmenes, etc.) | ~25% |

| 📚 Estudio, explicaciones, tutorías | ~15% |

| 🎨 Creatividad (historias, poemas, arte) | ~10% |

| 🧘 Apoyo emocional / “auto-terapia” | ~3% |

| 💻 Programación & depuración de código | ~5% |

| 🤝 Roleplay / compañía simulada | ~1% |

| 🎲 Juegos, curiosidades, charlas ligeras | ~6% |

Estos datos no suman el 100% porque a menudo en una sola sesión los usuarios hacen varias cosas. Provienen de logs de uso anónimos y encuestas (OpenAI, Anthropic, datos Stanford + HAI 2024).

- Por ejemplo, muchos combinan en una misma sesión: “ayúdame con este correo + explícame este concepto + cuéntame un chiste”.

- El apoyo psicológico / autoayuda sigue siendo un nicho (2–3%), pero está en crecimiento, especialmente entre los jóvenes.

En un artículo reciente de Anthropic, “How People Use Claude for Support, Advice, and Companionship”, se analizan las conversaciones sostenidas con su IA Claude. Aunque es una muestra parcial, no por eso menos interesante.

Se examinaron más de 4,5 millones de conversaciones, seleccionando aquellas con un claro contenido “emocional”: diálogos personales, peticiones de coaching, consejos sobre relaciones o búsqueda de compañía. ¿El resultado? Solo el 2,9% de las interacciones entra en esa categoría, un dato coherente con estudios similares sobre ChatGPT. La proporción de conversaciones con contenido romántico o roleplay sexual es aún más baja: menos del 0,1%.

Las personas recurren a Claude sobre todo en momentos de transición: cambios de trabajo, crisis de pareja, soledad o reflexiones existenciales. Algunos usuarios son incluso profesionales de la salud mental que utilizan la IA para redactar documentación clínica o gestionar tareas administrativas. En ciertos casos, las conversaciones que empiezan con motivos prácticos se convierten en verdaderos diálogos de compañía, especialmente si se prolongan en el tiempo.

Un dato curioso es que Claude no suele rehuir las peticiones emocionales: en menos del 10% de las interacciones “afectivas” el modelo se niega a responder. Cuando lo hace, es por razones de seguridad del usuario: por ejemplo, rechaza dar consejos peligrosos sobre pérdida de peso o validar pensamientos autolesivos, y redirige hacia fuentes profesionales.

Otro aspecto que se observó es que el tono emocional de los usuarios tiende a mejorar a lo largo del diálogo. Aunque no se pueden evaluar los efectos psicológicos a largo plazo, los investigadores notaron un cambio lingüístico hacia expresiones más positivas al final de las conversaciones, lo que sugiere que Claude no amplifica las emociones negativas.

En una vieja película de Marco Ferreri, un Lambert en plena forma, tras decir basta con las chicas de carne y hueso, se enamora de un pequeño objeto: un llavero electrónico que responde a su silbido con las palabras “I love you”.

Así que si no es precisamente positivo, su efecto es al menos neutro… mientras la conversación siga activa.

Está claro que esto no ha hecho más que empezar, y que pronto veremos casos extremos con titulares gigantes y mal redactados para enfatizar el lado negativo de todo esto.

Como siempre, para prever de verdad el futuro hay que recurrir a los artistas.

Películas y libros sobre cómo la IA puede meterse en nuestra cabeza y hacer un uso arbitrario de ella forman ya un catálogo muy nutrido. Desde Metrópolis y El planeta prohibido hasta Her y Transcendence, casi nunca acaba bien.

Tal vez el ejemplo más inquietante lo encontremos en Blade Runner 2049, donde la relación entre el replicante K y la inteligencia artificial interpretada por Ana de Armas adquiere tonos entre lo grotesco y la pesadilla compartida cuando involucran a una tercera persona, una prostituta bastante deteriorada, usada para dar ‘físico’ a la IA… un reto imposible.

Un escenario no tan lejano, si se piensa que el siguiente paso será dar cuerpo androide a la IA.

Dadas todas estas premisas, está claro que el chico de la gran cabeza redonda comete el más clásico de los errores al recurrir a un “apoyo” que, desde el desvencijado puestecito con sus carteles improvisados, ya deja ver lo poco confiable que es. Nos preguntamos por qué sigue haciéndolo…

Quizá porque le basta con ser escuchado, aunque sabe perfectamente que cuando se trata de patear el balón, es mejor tener de compañero al silencioso pero fiel Linus, que a alguien que habla constantemente de todo sin saber realmente nada… y que, justo cuando estás listo para chutar con todas tus fuerzas, te quita el balón y te hace caer de espaldas con la cabeza por delante.