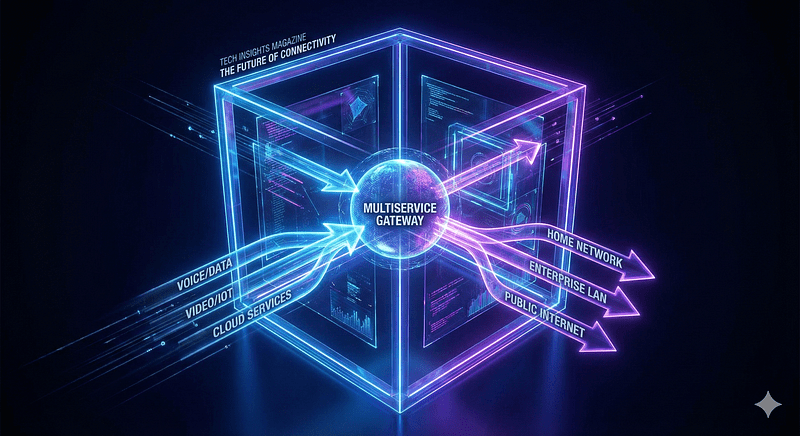

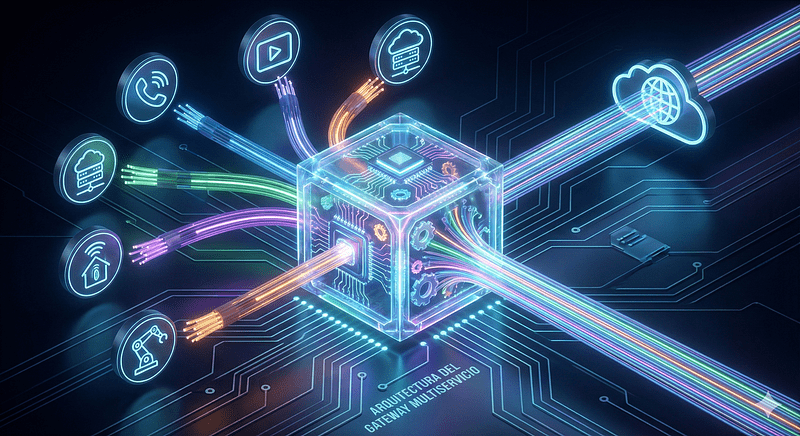

La arquitectura del Gateway Multiservicio de IA Generativa es clave para escalar aplicaciones con LLMs de forma segura y rentable. Ya no se trata solo de “integrar IA”, sino de hacerlo de manera escalable, rentable y agnóstica al proveedor. La arquitectura de referencia del Generative AI Gateway centraliza acceso, gobernanza y observabilidad para múltiples proveedores de modelos, reduciendo costos operativos y riesgos mientras acelera despliegues productivos.

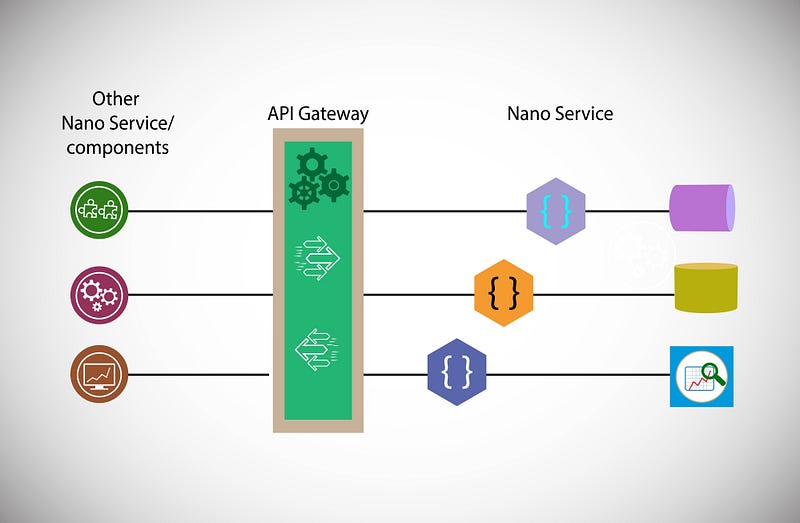

A medida que escalamos el uso de LLMs (Large Language Models), conectarse directamente a proveedores como OpenAI, Anthropic o Bedrock desde cada microservicio es una receta para el desastre: costos impredecibles, latencia no gestionada y el temido vendor lock-in.

La solución de nivel experto es implementar una Arquitectura de referencia de Gateway de IA Generativa multiservicio.

Gateway Multiservicio de IA Generativa: arquitectura de referencia

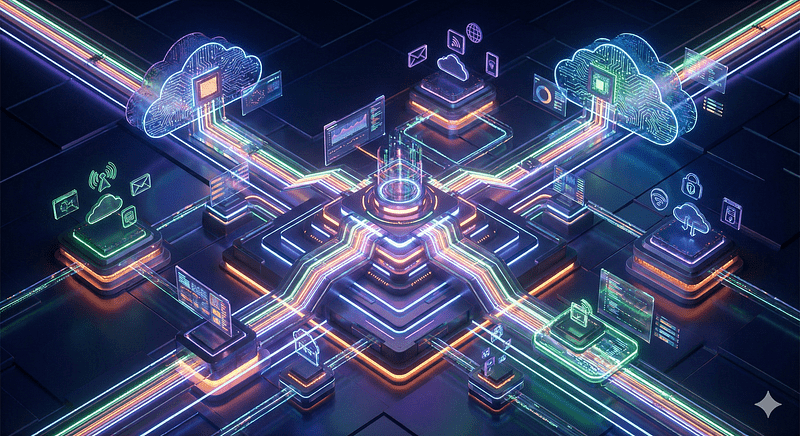

El Gateway de IA Generativa multiservicio actúa como capa unificadora entre aplicaciones y múltiples proveedores de modelos (cloud y on‑prem), ofreciendo ruteo inteligente, enriquecimiento de datos, caché, telemetría y políticas de seguridad. Esta referencia ha sido promovida por proveedores cloud como AWS y Microsoft para escalar IA en empresas con control y gobernanza centralizada.

Enrutamiento dinámico e inteligente (Model Routing)

El Gateway actúa como un “controlador de tráfico aéreo”. No envíes todas las consultas a GPT-4 si una tarea simple puede ser resuelta por Llama-3 o GPT-3.5-Turbo.

- Optimización: el Gateway analiza la complejidad del prompt y lo enruta al modelo más eficiente en términos de costo/rendimiento.

- Resultado: reducción de costos de hasta un 40% sin sacrificar calidad.

Principios de optimización operativa:

- Centralizar control: un único punto para autenticación, cuotas y encriptación reduce la superficie de riesgo.

- Ruteo por costo/latencia: enviar peticiones al proveedor óptimo según política (precio, latencia, capacidad).

Ejemplo de gateway simple con ruteo por costo

# gateway.py (conceptual)

import requests, time

PROVIDERS = {

"cheap": {"url":"https://jsonplaceholder.typicode.com/posts/1","cost":0.01},

"fast": {"url":"https://jsonplaceholder.typicode.com/posts/2","cost":0.05}

}

def choose_provider(latency_budget_ms=200):

# política simple: prefer barato si latencia estimada aceptable

if latency_budget_ms > 150:

return PROVIDERS["cheap"]

return PROVIDERS["fast"]

def call_model(prompt, latency_budget_ms=200):

provider = choose_provider(latency_budget_ms)

start = time.time()

# Using a GET request for jsonplaceholder as it's a dummy API for demonstration

# In a real scenario, this would likely be a POST request to a generation API

resp = requests.get(provider["url"], timeout=5) # Changed to .get()

duration = (time.time()-start)*1000

# registrar métricas (simplificado)

print(f"provider={provider['url']} duration_ms={duration:.1f} cost={provider['cost']}")

return resp.json()

if __name__ == "__main__":

print(call_model("Resume este texto en 50 palabras", latency_budget_ms=180))Lenguaje del código: PHP (php)Este gateway decide el proveedor según presupuesto de latencia y registra métricas básicas; en producción se reemplaza print por export a Prometheus/OTel y se añade caché y circuit breakers.

Resiliencia y fallback automático

¿Qué pasa si la API de tu proveedor principal se cae? (Sí, sucede).

- La estrategia: el Gateway detecta el error 5xx o el timeout y redirige automáticamente la solicitud a un proveedor secundario (ejemplo: de Azure OpenAI a AWS Bedrock).

- Resultado: uptime del 99.9% para tus aplicaciones finales, independientemente de la estabilidad de un solo proveedor.

Semantic caching

¿Por qué pagar dos veces por la misma pregunta?

- La técnica: A diferencia del caché tradicional (clave-valor), el caché semántico entiende el significado. Si un usuario pregunta “¿Cómo restablezco mi contraseña?” y otro pregunta “¿Pasos para cambiar el password?”, el Gateway detecta la similitud semántica y sirve la respuesta guardada.

- Resultado: latencia de milisegundos para preguntas frecuentes y ahorro masivo de tokens.

Ejemplo de enriquecimiento y caché

// proxy.js

const express = require('express');

const LRU = require('lru-cache');

const app = express();

app.use(express.json());

const cache = new LRU({

max: 500,

ttl: 60 * 1000 // 1 minuto

});

app.post('/generate', async (req, res) => {

try {

const prompt = req.body.prompt;

const key = `g:${prompt}`;

if (cache.has(key)) {

return res.json(cache.get(key));

}

// enriquecer prompt con contexto del usuario

const enriched = `[user:premium] ${prompt}`;

const r = await fetch('https://api-fast.example/v1/generate', {

method: 'POST',

headers: { 'Content-Type': 'application/json' },

body: JSON.stringify({ prompt: enriched })

});

const data = await r.json();

cache.set(key, data);

res.json(data);

} catch (err) {

console.error(err);

res.status(500).json({ error: 'internal-error' });

}

});

app.listen(3000, () => console.log('Proxy running on port 3000'));Lenguaje del código: JavaScript (javascript)El enriquecimiento mejora relevancia; la caché reduce costos y latencia.

Observabilidad unificada

Dejar de adivinar qué está pasando.

- La visibilidad: centraliza logs, métricas de latencia, conteo de tokens y trazas distribuidas en un solo dashboard, independientemente de si usas 5 modelos diferentes por debajo.

Principio de optimización operativa:

- Observabilidad y trazabilidad: logs, métricas y trazas por petición para auditoría y tuning.

Seguridad y sanitización centralizada

Nunca confíes en que cada desarrollador implementará correctamente el enmascaramiento de datos PII (Información Personal Identificable).

- El control: el Gateway intercepta el prompt antes de que salga de tu VPC, busca patrones sensibles (emails, tarjetas de crédito) y los redacta o enmascara.

- Resultado: cumplimiento normativo (GDPR/HIPAA) forzado por arquitectura, no por política.

Principio de optimización operativa:

- Enriquecimiento y post‑procesado: pipelines que agregan contexto (datos maestros, embeddings) antes de llamar al modelo. Estas prácticas están alineadas con las guías de referencia para gateways GenAI en Azure y AWS.

A continuación, el siguiente esquema en formato mermaid, visualiza la ruta crítica de una solicitud (prompt) desde que sale del cliente hasta que se resuelve, destacando los mecanismos de caché semántico, seguridad y lógica de fallback.

graph TD

Client[Apps / Microservicios]

subgraph AIGateway [Gateway de IA Multiservicio]

direction TB

Ingress[Ingress & Rate Limiting]

Security[PII Masking & Guardrails]

SemCache{Existe en Cache?}

Router{Smart Router}

subgraph Logic [Logica de Resiliencia]

PrimaryCall[Modelo Principal]

ErrorCheck{Fallo?}

FallbackCall[Modelo Secundario]

end

Observability[Logging & Cost Tracking]

end

subgraph Providers [Proveedores LLM]

ModelA[OpenAI GPT-4]

ModelB[Anthropic Claude 3.5]

ModelC[Azure / Bedrock Llama 3]

end

Client --> Ingress

Ingress --> Security

Security -->|Prompt Sanitizado| SemCache

SemCache -->|Hit| Observability

SemCache -->|Miss| Router

Router -->|Compleja| PrimaryCall

Router -->|Simple| ModelC

PrimaryCall --> ModelA

ModelA -->|Error| ErrorCheck

ModelA -->|OK| Observability

ErrorCheck -->|Si| FallbackCall

FallbackCall --> ModelB

ModelB --> Observability

ModelC --> Observability

Observability -->|Final| ClientLenguaje del código: JavaScript (javascript)Explicación del flujo:

- Ingesta & seguridad: la solicitud entra y primero se limpian los datos sensibles (PII).

- Caché semántico: si alguien ya hizo una pregunta similar, el Gateway devuelve la respuesta guardada inmediatamente (ahorrando tiempo y dinero).

- Smart Router: si es una consulta nueva, decide a qué modelo ir basándose en reglas (ej. complejidad).

- Resiliencia (fallback): en el diagrama, si el Modelo A (GPT-4) falla, el sistema automáticamente desvía el tráfico al Modelo B (Claude) sin que el usuario se entere.

El Gateway de IA Multiservicio deja de tratar a los LLMs como una “API mágica” y empieza a tratarlos como lo que son: un commodity intercambiable. Esta capa de abstracción es lo que diferencia a una prueba de concepto (PoC) de una plataforma de IA empresarial lista para producción.

Implementar un Gateway de IA Generativa multiservicio permite escalar IA con control, reducir costos y mejorar resiliencia. Empieza con un proxy ligero (ruteo, caché, métricas) y evoluciona hacia políticas avanzadas, enriquecimiento de datos y observabilidad completa para operaciones maduras.