La ineficiencia oculta de JSON frente a la revolución de TOON vs JSON en LLMs está transformando cómo optimizamos tokens, velocidad y costes en inteligencia artificial. En el desarrollo de software tradicional, JSON (JavaScript Object Notation) es el rey indiscutible. Es legible, estructurado y universal. Pero aquí está la verdad incómoda que nadie te dijo al empezar a construir con IA: A los LLMs no les importa la “pureza” de tu estructura de datos; les importan los tokens.

Si sigues enviando y recibiendo grandes bloques de JSON a modelos como GPT-4, Claude 3.5 o Llama 3, estás desperdiciando ancho de banda semántico, aumentando la latencia y, literalmente, quemando tu presupuesto.

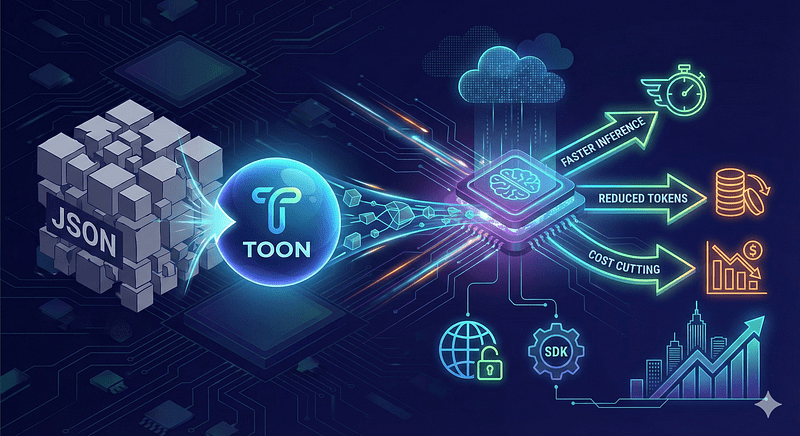

Hace poco se lanzó TOON, y la industria no ha dejado de hablar de ello. TOON (Token‑Oriented Object Notation) reemplaza JSON plano en prompts y payloads para LLMs, reduciendo tokens, acelerando inferencia y recortando costes; su especificación y SDK están disponibles públicamente y muestran mejoras prácticas para producción.

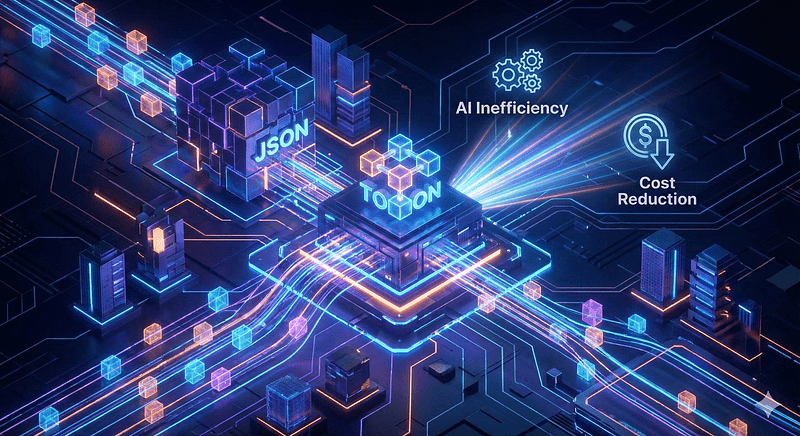

TOON vs JSON en LLMs: ¿Por qué importa?

TOON es una notación compacta y consciente del esquema diseñada específicamente para alimentar modelos de lenguaje con datos estructurados de forma más eficiente que JSON tradicional. No es un simple atajo de sintaxis: es una representación pensada para minimizar tokens redundantes y mantener legibilidad humana y compatibilidad con esquemas y validaciones.

TOON ha llegado para eliminar la grasa y dejar solo el músculo. Diseñado específicamente para la inferencia de LLMs, TOON prioriza la densidad semántica sobre la rigidez sintáctica.

El problema: la “Taxa de Sintaxis” de JSON

Para entender por qué JSON es ineficiente para la IA, primero debemos entender cómo “leen” los modelos: Tokenización.

Los LLMs usan tokenizadores (como BPE — Byte Pair Encoding). Cada carácter cuenta, pero los caracteres “comunes” se agrupan. Sin embargo, JSON está lleno de caracteres que son “veneno” para la eficiencia de los tokens:

- Comillas dobles (

"): repetidas miles de veces para claves y valores. - Llaves y corchetes (

{},[]): estructura rígida. - Espacios en blanco y saltos de línea: formato visual que consume contexto.

En un prompt promedio de RAG (Retrieval-Augmented Generation), la sintaxis de JSON puede ocupar entre el 15% y el 25% de tus tokens totales. Eso es un 25% de tu ventana de contexto que no estás usando para razonamiento o datos.

¿Qué hace a TOON diferente?

- Eliminación de redundancia: TOON descarta las comillas en las claves (keys) y utiliza delimitadores que suelen ser tokens únicos en la mayoría de los vocabularios de los modelos (como

|o indentación mínima). - Compresión de arrays: en lugar de repetir estructuras, utiliza definiciones de esquema implícitas que el LLM entiende naturalmente.

- Token-friendly: está diseñado para alinearse con cómo los tokenizadores BPE agrupan las palabras.

Ejemplo práctico de TOON vs JSON en LLMs

Miremos un ejemplo simple de un objeto de usuario.

- El enfoque JSON:

[

{

"id": 101,

"nombre": "Ana García",

"rol": "admin",

"activo": true

},

{

"id": 102,

"nombre": "Beto Pérez",

"rol": "user",

"activo": false

}

]Lenguaje del código: JSON / JSON con comentarios (json)Gasto aproximado: ~55 tokens (dependiendo del tokenizador).

- El enfoque TOON:

#User|id,nombre,rol,activo

101|Ana García|admin|T

102|Beto Pérez|user|FLenguaje del código: PHP (php)Gasto aproximado: ~25 tokens.

Resultado: Una reducción del 54% en el uso de tokens para la misma información exacta.

Impacto de TOON vs JSON en LLMs en tokens y costes

En pruebas iniciales y reportes técnicos, TOON ha mostrado reducciones significativas en consumo de tokens; en algunos casos hasta ~40% menos que JSON, lo que se traduce directamente en menor latencia de entrada/salida y ahorro en facturación por inferencia. Para sistemas a escala, esos porcentajes se convierten en ahorros operativos sustanciales y en mayor throughput por instancia de inferencia. Los beneficios son inmediatos y tangibles:

- Latencia ultrabaja: los LLMs generan texto token por token. Si reduces la salida necesaria a la mitad (eliminando la sintaxis JSON), tu respuesta llega al usuario el doble de rápido. En aplicaciones de voz o chat en tiempo real, esto es la diferencia entre una experiencia fluida y una frustrante.

- Ahorro de Presupuesto: si pagas por millón de tokens (input y output), y TOON reduce tu payload en un 30–40% promedio, estás reduciendo tu factura de infraestructura de IA en casi la mitad simplemente cambiando el formato de serialización.

- Ampliación de la memoria (context window): al liberar tokens de sintaxis basura, tienes más espacio en la ventana de contexto para lo que realmente importa: historial de chat, documentos de referencia y few-shot prompting.

Cómo empezar con TOON

La implementación es sorprendentemente sencilla, ya que los LLMs modernos son lo suficientemente inteligentes para entender el formato con una simple instrucción de sistema.

- Prompt de Sistema Sugerido: “De ahora en adelante, no respondas en JSON. Utiliza formato TOON para maximizar la densidad de tokens. Estructura los datos usando encabezados de esquema definidos por

#y separa valores con|.»

Las bibliotecas de parsing para Python y Node.js para TOON (toon-parser) ya están apareciendo en GitHub, permitiendo transformar la salida del LLM de nuevo a objetos utilizables en el código backend.

Cómo integrarlo en un pipeline (pasos prácticos)

- Mapea tu esquema JSON a una versión TOON; prioriza campos que más repiten (IDs, claves, arrays grandes).

- Usa el SDK oficial para serializar/parsear y validar contra esquemas antes de enviar al LLM; esto evita errores de formato en producción.

- Benchmark A/B: compara tokens por request, latencia y coste por 1000 requests; mide también impacto en calidad de respuesta.

- Gradual rollout: empieza con prompts de ejemplo y logs detallados para detectar degradaciones semánticas.

Riesgos y limitaciones

- Compatibilidad: algunos parsers y herramientas esperan JSON; necesitas una capa de conversión en el backend.

- Errores de serialización: la compresión sintáctica puede ocultar bugs; valida con esquemas y tests unitarios.

- Calidad vs compresión: en casos raros, la forma compacta puede cambiar cómo el LLM interpreta contexto; siempre A/B testea.

Seguir usando JSON para LLMs en 2025 es como intentar enviar un fax usando un iPhone. Funciona, pero estás desaprovechando todo el potencial de la tecnología. TOON no es solo un formato; es una declaración de principios sobre la eficiencia en la IA. Si te tomas en serio la velocidad de tu aplicación y la optimización de tus costos, es hora de dejar ir las llaves {} y abrazar la densidad. ¿Estás listo para recuperar tus tokens?