¡Despega hacia el futuro de la Inteligencia Artificial! Prepárate para entender desde cero como las redes neuronales artificiales (RNA) son el corazón de la inteligencia artificial moderna y cómo estas estructuras inspiradas en el cerebro humano están revolucionando el mundo, permitiendo que las máquinas aprendan patrones complejos a partir de datos. Desde el reconocimiento de imágenes hasta los modelos de lenguaje como Transformers, todo como parte de este concepto revolucionario.

¿Qué es una red neuronal artificial y cómo funciona?

Imagina el cerebro humano con sus miles de millones de neuronas interconectadas, trabajando en paralelo para procesar información, aprender y tomar decisiones. Una Red Neuronal Artificial (RNA) es un modelo computacional que imita esta arquitectura biológica.

No es un cerebro, sino un algoritmo de Machine Learning (Aprendizaje Automático) que aprende a realizar tareas (como reconocer imágenes o traducir idiomas) analizando grandes cantidades de datos y encontrando patrones por sí mismo, sin necesidad de ser programado explícitamente para cada regla.

- Una red neuronal es un modelo matemático compuesto por capas de nodos (neuronas artificiales).

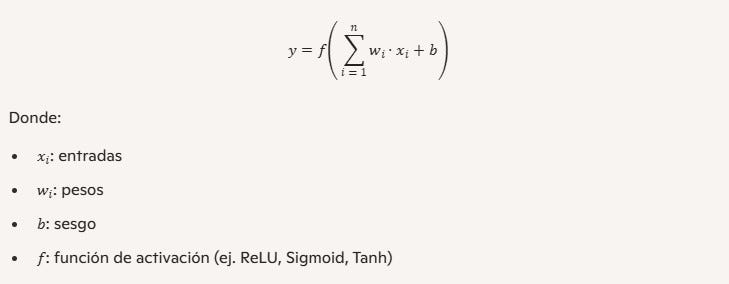

- Cada neurona recibe entradas, las multiplica por pesos, suma un sesgo (bias) y aplica una función de activación.

- El objetivo: aproximar funciones que transformen entradas en salidas útiles.

Fórmula básica de una neurona

Componentes clave de una red neuronal artificial

Una RNA se construye con tres elementos fundamentales:

- Neuronas (o nodos): Son las unidades básicas de procesamiento, organizadas en capas. Cada neurona recibe entradas, realiza un cálculo simple y produce una salida.

- Conexiones y pesos: Cada conexión entre neuronas tiene un valor numérico llamado peso. Este peso determina la fuerza o importancia de la entrada. Una neurona suma sus entradas multiplicadas por sus respectivos pesos, y a esa suma le añade un valor constante llamado sesgo (bias).

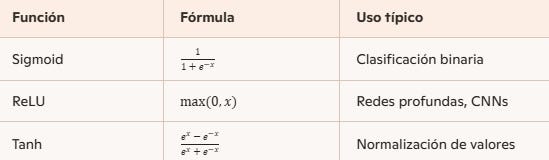

- Función de activación: El resultado de la suma ponderada pasa a través de una función matemática que decide si la neurona debe “activarse” (transmitir una señal a la siguiente capa) y con qué intensidad. Esto introduce la no linealidad esencial para aprender patrones complejos.

La estructura de capas y el flujo de información

Una red neuronal típica se organiza en al menos tres capas:

1. Capa de entrada (Input Layer): Recibe la información inicial. Por ejemplo, si la red va a reconocer una imagen, la capa de entrada tendrá un nodo por cada píxel de la imagen.

2. Capas ocultas (Hidden Layers): Aquí ocurre la magia del procesamiento. Las capas ocultas realizan todos los cálculos intermedios, extrayendo características y patrones complejos de los datos.

- Una red se considera de Aprendizaje Profundo (Deep Learning) cuando tiene al menos dos o más capas ocultas, permitiéndole manejar problemas de complejidad extrema.

3. Capa de salida (Output Layer): Produce el resultado final de la red. Si la tarea es clasificar una imagen en “perro” o “gato”, la capa de salida tendrá dos nodos, y el que tenga el valor más alto será la predicción.

El secreto del aprendizaje: propagación y ajuste

¿Cómo aprende la red neuronal? A través de un proceso iterativo de ensayo y error en dos fases principales, usando datos de entrenamiento etiquetados:

- Propagación hacia adelante (forward propagation)

- Los datos de entrenamiento ingresan por la capa de entrada.

- La información fluye a través de las capas, nodo por nodo, hasta la capa de salida.

- La red produce una predicción.

- Retropropagación (backpropagation) y optimización

- Cálculo del Error: Se utiliza una función de pérdida (o costo) para medir la diferencia o el error entre la predicción de la red y el resultado real esperado (la etiqueta correcta).

- Retropropagación: El error se propaga hacia atrás a través de la red (de la capa de salida a las capas ocultas y de entrada).

- Ajuste de Pesos: Utilizando el cálculo del error (mediante un proceso llamado Descenso de Gradiente), la red ajusta los pesos y los sesgos de todas las conexiones para que, en la siguiente iteración, el error sea menor.

Este ciclo de Propagación → Error → Ajuste de Pesos se repite miles o millones de veces (llamadas épocas) hasta que el error es mínimo, y la red ha aprendido la relación entre la entrada y la salida con alta precisión.

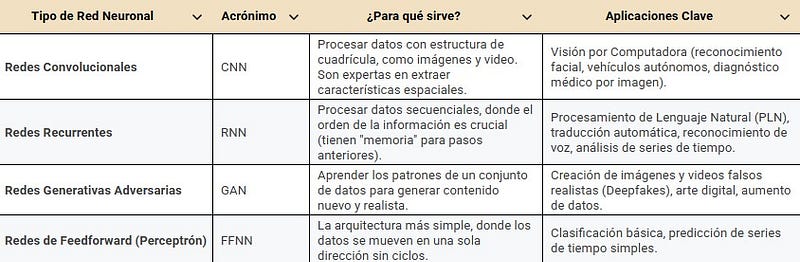

Tipos clave de redes y sus aplicaciones estelares

No todas las redes neuronales son iguales. Sus arquitecturas varían para adaptarse mejor a diferentes tipos de datos y problemas.

Ejemplo práctico desde cero (Python + NumPy)

Primero, construyamos una red neuronal manual para clasificar datos simples:

import numpy as np

# Datos de ejemplo (XOR problem)

X = np.array([[0,0],[0,1],[1,0],[1,1]])

y = np.array([[0],[1],[1],[0]])

# Inicialización de pesos

np.random.seed(42)

W1 = np.random.randn(2, 2) # pesos capa oculta

b1 = np.zeros((1, 2))

W2 = np.random.randn(2, 1) # pesos capa salida

b2 = np.zeros((1, 1))

# Función de activación (sigmoid)

def sigmoid(z):

return 1 / (1 + np.exp(-z))

# Entrenamiento simple

lr = 0.1

for epoch in range(10000):

# Forward

z1 = X.dot(W1) + b1

a1 = sigmoid(z1)

z2 = a1.dot(W2) + b2

a2 = sigmoid(z2)

# Backpropagation

error = y - a2

d2 = error * a2 * (1 - a2)

d1 = d2.dot(W2.T) * a1 * (1 - a1)

# Actualización de pesos

W2 += a1.T.dot(d2) * lr

b2 += np.sum(d2, axis=0, keepdims=True) * lr

W1 += X.T.dot(d1) * lr

b1 += np.sum(d1, axis=0, keepdims=True) * lr

# Predicciones

print("Predicciones finales:")

print(a2.round())Lenguaje del código: PHP (php)Este código entrena una red neuronal desde cero para resolver el clásico problema XOR, que es un ejemplo fundamental en el aprendizaje automático y la inteligencia artificial que pone en evidencia las limitaciones de los modelos lineales.

Ejemplo con librerías modernas (PyTorch)

Ahora, la misma idea pero con PyTorch, mucho más práctico:

import torch

import torch.nn as nn

import torch.optim as optim

# Datos XOR

X = torch.tensor([[0,0],[0,1],[1,0],[1,1]], dtype=torch.float32)

y = torch.tensor([[0],[1],[1],[0]], dtype=torch.float32)

# Definición de la red

class XORNet(nn.Module):

def __init__(self):

super(XORNet, self).__init__()

self.hidden = nn.Linear(2, 2)

self.output = nn.Linear(2, 1)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

x = self.sigmoid(self.hidden(x))

x = self.sigmoid(self.output(x))

return x

# Entrenamiento

model = XORNet()

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.1)

for epoch in range(10000):

optimizer.zero_grad()

outputs = model(X)

loss = criterion(outputs, y)

loss.backward()

optimizer.step()

print("Predicciones finales:")

print(model(X).round().detach())Funciones de activación más comunes

Aplicaciones reales de las redes neuronales artificiales

Las RNA son el motor de la revolución actual de la IA, impulsando innovaciones en casi todos los sectores:

- Medicina: Detección temprana de enfermedades (tumores, retinopatías) analizando imágenes médicas con mayor velocidad y precisión que un ojo humano.

- Finanzas: Detección de fraudes en tiempo real analizando patrones de transacciones atípicas y modelos de riesgo predictivo.

- Tecnología: Motores de recomendación de Netflix o Amazon, asistentes virtuales como Siri y Alexa, y sistemas de traducción automática como Google Translate.

- Robótica y Automatización: Control de robots industriales y la toma de decisiones en vehículos autónomos.

¡La Red Neuronal no es magia, es matemática!

Es la forma en que logramos que una máquina aprenda de la experiencia a un nivel de complejidad sin precedentes, acercándonos cada vez más a replicar la increíble capacidad de la inteligencia natural. Entender sus fundamentos es comprender el pilar de la IA moderna. ¡El futuro está aquí, y está conectado!