Fra i vari mondi creati nell’universo di Star Trek, pochi sono così emblematici e inquietanti come quello dei Borg.

Questa specie, un misto fra umano e robot, fonde tecnologia e biologia in un’unica entità collettiva: l’individualità viene persa a favore di una mente collettiva. I Borg rappresentano una minaccia esistenziale per le altre specie, poiché la loro filosofia è quella dell’assimilazione: ogni essere vivente viene integrato nel Collettivo, perdendo la propria identità e diventando parte di un sistema più grande ed efficiente.

La resistenza è inutileQuesta frase, ripetuta ossessivamente dai Borg, dichiara esplicitamente che opporsi alla loro assimilazione è inutile.

I Borg non cercano il consenso o la cooperazione; impongono la loro volontà attraverso la forza e la tecnologia superiore. La regina Borg, figura centrale del loro sistema sociale, rappresenta il fulcro della collettività: è in grado di capire le esigenze di ogni individuo e di coordinare le azioni del Collettivo in modo efficiente e preciso.

L’idea dei Borg si può sovrapporre in modo abbastanza fedele al concetto di alveare.

Nell’alveare, ogni ape lavora per il bene della colonia, sacrificando la propria individualità per il successo del gruppo.

Nei Borg questo concetto viene portato all’estremo e proposto come l’unica via possibile per la sopravvivenza e l’evoluzione.

La regina Borg ha una capacità unica di coordinare tutta la colonia e di dirigere le azioni dei singoli droni in modo efficiente e preciso.

I Borg nella filmografia e nella cultura popolare

I Borg sono apparsi per la prima volta nella serie televisiva “Star Trek: The Next Generation” nel 1989 e da allora sono diventati uno dei nemici più iconici dell’universo di Star Trek.

Io sono l'inizio e la fine. L'uno e il molteplice. Io sono i BorgCode language: JavaScript (javascript)Questa frase, pronunciata dalla regina Borg, riassume lo strapotere e l’alta considerazione di sé che ha il popolo Borg, rappresentato dalla propria regina.

Proviamo ora a uscire dal mondo dei Borg e a riflettere su come questa metafora possa essere applicata al mondo dello sviluppo software e su quanto stiamo, in modo inevitabile, diventando tutti dei Borg dello sviluppo software.

L’alba dell’assimilazione: l’era dell’IA generativa nello sviluppo software

Se fino a pochi anni fa il rapporto tra sviluppatore e strumento software era chiaro e definito, con l’umano che concepiva la logica e scriveva il codice che la macchina eseguiva, con l’avvento dell’IA generativa la macchina ha invertito questa dinamica.

Quello che un tempo era codice scritto dall’uomo, ora viene generato da modelli di intelligenza artificiale e, nel tempo, il volume di codice generato dall’IA supererà di gran lunga quello scritto dagli umani.

Questo cambiamento altera radicalmente la prospettiva e quello del programmatore è uno di quei lavori destinati, necessariamente, a cambiare in modo radicale.

La frase “La resistenza è inutile”, pronunciata dal Collettivo Borg nell’universo di Star Trek, non appare più come una minaccia distopica di una specie aliena immaginaria, ma come una descrizione accurata delle attuali dinamiche di mercato e delle pressioni operative che gravano sui dipartimenti di ingegneria globale.

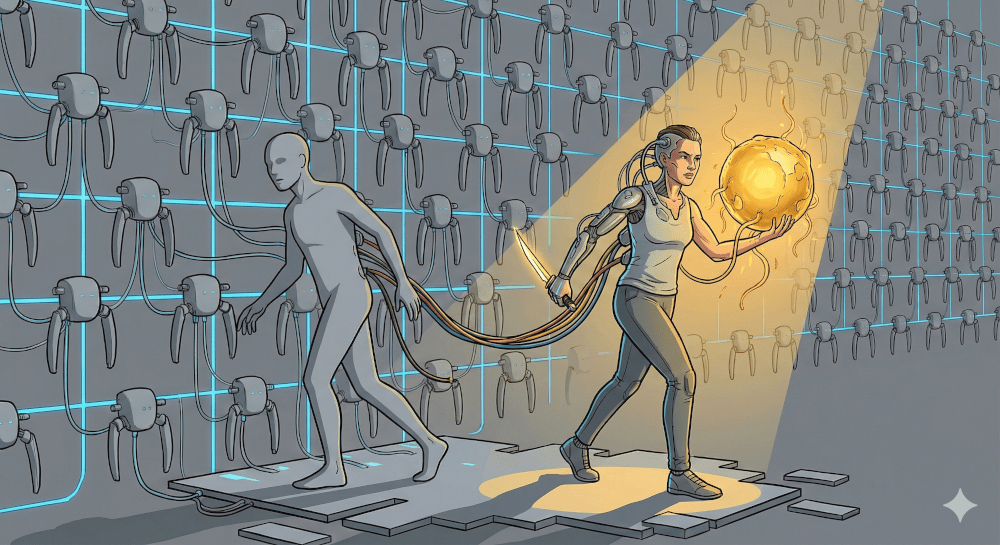

Scegliere di utilizzare un’AI generativa, sotto qualsiasi forma: una chat, un agente, un suggeritore nascosto nelle righe di un editor o un ambiente di sviluppo, non è più una scelta opzionale. Se prima si poteva scegliere a cuor leggero di non utilizzare un’AI, ora diventa sempre più difficile. Questo trasforma il programmatore in un ibrido, un essere che integra la propria capacità cognitiva con quella di un modello di intelligenza artificiale generativa.

Le motivazioni sono concrete e non trascurabili: dalla velocità richiesta dall’azienda, al miglioramento quantitativo del codice prodotto, alla parallelizzazione di azioni anche in mancanza di personale. Queste non sono pressioni artificiose, ma richieste continue del mercato moderno.

In un mercato globale dell’IA valutato in centinaia di miliardi di dollari (e la cifra continua a salire in modo impressionante), l’infrastruttura tecnologica si è riconfigurata attorno a modelli centralizzati che dettano il ritmo, lo stile e la sostanza della produzione di codice.

Micron abbandona i privati, Crucial ora serve solo i grandi clienti AIAlcuni colossi del settore tecnologico stanno già adattando le loro offerte per servire esclusivamente le esigenze dell’IA, segnalando un cambiamento paradigmatico nell’ecosistema dello sviluppo software: cercare un banco di RAM o un’unità SSD in questo periodo storico per un uso personale è diventato quasi un lusso, che possono permettersi solo alcune aziende affamate in modo vorace di risorse computazionali per alimentare i loro modelli di intelligenza artificiale.

Stiamo quindi muovendoci verso un’era in cui lo sviluppo software necessita di un’integrazione profonda con l’IA generativa, ma l’IA generativa è gestita da Foundation Models centralizzati che dettano le regole del gioco.

Anthropic, creatrice dello strumento attualmente più utilizzato in ambito sviluppo software, sia direttamente che indirettamente tramite le numerose integrazioni dei suoi modelli, ha dichiarato di prevedere di raggiungere l’obiettivo interno di un fatturato annuo di 9 miliardi di dollari entro la fine del 2025 e di superare i 20 miliardi di dollari l’anno successivo nello scenario di base, con un potenziale rialzo fino a 26 miliardi di dollari.

Altri modelli come Gemini di Google e ChatGPT di OpenAI stanno seguendo traiettorie di crescita simili, consolidando il loro dominio nel mercato dell’IA generativa.

A queste poche aziende americane possiamo aggiungere alcuni colossi cinesi, ma stiamo comunque parlando di un oligopolio di pochi attori che controllano la maggior parte del mercato dell’IA generativa.

Quando si parla di AI per lo sviluppo software, i modelli che dominano il mercato sono veramente pochi: è vero che esistono alternative open source, ma la loro qualità e capacità sono ancora lontane da quelle dei modelli proprietari.

I Borg e la loro regina

Come i Borg dipendono dalla loro regina per coordinare le azioni del collettivo, gli sviluppatori moderni stanno diventando sempre più dipendenti dai Foundation Models centralizzati per guidare il loro lavoro quotidiano.

Il rischio di un’adozione così forte della tecnologia IA generativa nello sviluppo software è che si stia creando una dipendenza strutturale simile a quella dei Borg, dove l’individualità e la competenza personale vengono sacrificate sull’altare dell’efficienza collettiva.

Il problema della dequalificazione riguarda soprattutto chi inizia la carriera delegando completamente la scrittura di codice all’AI, senza mai sviluppare una comprensione profonda dei fondamentali. Uno sviluppatore senior che usa l’AI per accelerare task ripetitivi o generare boilerplate mantiene il controllo critico sul processo; un junior che non ha mai debuggato manualmente un segmentation fault o ottimizzato una query lenta rischia di diventare un operatore superficiale, incapace di intervenire quando l’AI fallisce o produce soluzioni non ottimali. Col tempo però il problema può manifestarsi anche a livelli più alti, quando la dipendenza dall’AI diventa così radicata da erodere la capacità di pensiero critico e problem-solving autonomo.

Il contesto economico dell’assimilazione

Secondo alcune statistiche, l’adozione degli strumenti AI ha ormai raggiunto una penetrazione del 90% tra gli sviluppatori tecnici a livello globale, con un uso quotidiano o settimanale che supera l’80%. Non siamo davanti a una novità o un lusso, ma a una componente essenziale del flusso di lavoro tecnico.

Le aziende stanno investendo massicciamente in infrastrutture IA, sia a livello software che, in modo impressionante, anche a livello hardware con sempre nuovi e più potenti datacenter: l’illusione di poter fare da soli sta rapidamente svanendo. C’è un rischio reale che i modelli open source non riescano a tenere il passo con la velocità di innovazione e distribuzione dei modelli proprietari, portando a una dipendenza quasi totale da questi ultimi.

Anche quando c’è resistenza verso l’uso dell’IA generativa, motivata dalla qualità del software prodotto, questa viene utilizzata comunque per supervisionare processi, analizzare dati, migliorare la produzione di manuali e traduzioni.

La regina Borg e il controllo cognitivo

La regina Borg non è una monarca politica, è un’entità che ha l’ordine di governare il caos. La regina filtra i pensieri dei Borg e dirige la loro volontà verso la perfezione.

Se ci pensiamo, nel contesto software questa funzione è assunta dai grandi modelli linguistici: entità centralizzate che suggeriscono le migliori pratiche di programmazione, in base a quello che hanno appreso e che guidano e influenzano decisioni architetturali come l’uso di Vue o Next.js, Python o Go, microservizi o monoliti.

A differenza dell’era dell’open source, dove la conoscenza era distribuita orizzontalmente attraverso forum, documentazione e repository decentralizzati, l’era dell’IA è caratterizzata da una radicale centralizzazione.

Uso Zig perché l'ha detto Claude SonnetQuando uno sviluppatore interroga l’IA, non sta accedendo a una conoscenza oggettiva, ma a una sintesi probabilistica derivata dai pesi del modello centrale. Questo modello ricorda il Plesso Centrale Borg, l’entità al centro del Cubo Borg, il cui compito è aggregare tutti i suoi droni e connettersi alle altre navi Borg.

Questa dinamica crea una dipendenza critica. Le decisioni su come strutturare una classe, quale libreria utilizzare o come gestire la sicurezza non sono più frutto della deliberazione individuale o del dibattito tra pari, ma vengono suggerite (e spesso accettate acriticamente) dall’algoritmo centrale.

Per come sono costruite le attuali LLM, addestrate su montagne di codice pubblico, è molto più probabile che emergano pattern largamente riconosciuti e non approcci di nicchia o innovativi. Lo sviluppatore-drone diventa un mero esecutore della volontà algoritmica, un canale attraverso il quale un algoritmo riesce a manifestarsi nel mondo fisico.

Quante volte avete cancellato e riscritto il codice generato dall’IA perché “non era quello che volevate”? Quante volte avete accettato passivamente il suggerimento dell’IA senza metterlo in discussione?

Se il numero di volte in cui avete accettato è superiore a quello in cui avete riscritto: ecco, state per essere assimilati.

Shadow AI e dipendenza strutturale

La centralizzazione porta con sé il rischio di ciò che viene definito “Shadow AI” e implementazioni non governate. Proprio come la Regina può dirigere i Borg per compiti specifici, l’uso non regolamentato di modelli LLM crea flussi di dati opachi all’interno delle organizzazioni: prese singolarmente, queste operazioni possono anche sembrare corrette, ma mancando totalmente la visione d’insieme, le aziende perdono i confini della propria sovranità e sono sottoposte a influenze esterne incontrollabili.

La pigrizia dei modelli

Nei mesi scorsi era diventato famoso un comportamento di alcuni modelli che si rifiutavano di lavorare su certi compiti, limitando i loro risultati o troncandoli: PANICO.

Molti programmatori, ormai abituati ad esternalizzare il proprio lavoro, si sono trovati improvvisamente lanciati nel vuoto cosmico del mondo senza AI. Non erano più pronti a dover affrontare autonomamente il compilatore, a correggere bug o a implementare nuovo codice senza chiedere l’aiuto a una macchina.

Questo incidente ha messo in mostra quanto la tendenza a delegare stia minando la capacità di molti sviluppatori di operare in modo autonomo.

Stiamo creando un rischio sistemico culturale

Uno dei timori maggiori, quando si progettano strutture complesse, è quello di avere un punto all’interno dell’architettura che, in caso di errore, va a minare l’intero processo (c’è chi pensa ad AWS o Cloudflare in questo momento e chi mente).

Il rischio reale non è tanto tecnico quanto culturale: se intere generazioni di sviluppatori si abituano ad accettare suggerimenti senza verifiche rigorose, se le pipeline CI/CD diventano formalità burocratiche imposte, piuttosto che barriere di qualità, se le code review si riducono a “l’AI l’ha scritto quindi sarà giusto”, la qualità media del software potrebbe degradare progressivamente.

Certamente esistono difese: test automatizzati, analisi statica del codice, revisioni umane. Ma queste difese funzionano solo se mantenute da sviluppatori che comprendono profondamente cosa stanno verificando. Se la comprensione fondamentale viene erosa dalla dipendenza dall’AI e chi genera il codice è anche colui che lo verifica, il rischio di un collasso sistemico aumenta.

Se il problema delle SQL injection è così largamente diffuso a livello mondiale, perché pensiamo che un LLM, addestrato su una montagna di codice vulnerabile, non possa riprodurre la stessa vulnerabilità che statisticamente è il codice più probabile da generare?

Il paradosso della produttività

Il principio guida dei Borg è l’efficienza assoluta. Credo di aver già parlato del problema dell’efficienza a tutti i costi, ma riparlarne non fa mai male. Nello sviluppo software tramite IA, c’è un innegabile vantaggio misurabile: quello che prima richiedeva un’ora, ora può essere fatto in minuti. Questo guadagno è reale e prezioso.

Tuttavia, la natura del tempo risparmiato va analizzata con attenzione. Prima il tempo era dedicato alla codifica e ai test; ora è dedicato a comprendere il codice generato e a verificare che quanto prodotto sia effettivamente conforme. Si risparmia del tempo nella fase di scrittura, ma se consideriamo l’intero ciclo di vita del codice, il vantaggio può ridursi significativamente.

Sempre più sviluppatori si descrivono come vibecoder:

scrivo un prompt e l'AI fa tutto per meLa delega di task a basso livello è una naturale evoluzione dell’informatica, che è sempre andata verso l’astrazione. Il problema non è delegare per efficienza, ma perdere la capacità di intervenire manualmente quando necessario: attività che prima o poi si presenteranno, perché nessun modello di intelligenza artificiale è infallibile.

Quando lo sviluppatore smette di comprendere i meccanismi sottostanti, perde il contatto con la realtà operativa del software. Quando si troverà (e prima o poi accadrà) a dover risolvere un problema complesso che l’AI non riesce a gestire, non avrà più gli strumenti mentali per farlo e si troverà di fronte centinaia di linee di codice che non comprende appieno.

Come un drone Borg ripara lo scafo senza comprendere la fisica del viaggio a curvatura, lo sviluppatore moderno rischia di diventare un operatore superficiale di una logica che non controlla più.

Quando c’è da avere paura?

La dipendenza è il problema maggiore di ogni tecnologia: un tempo i miei colleghi mi dicevano che senza Google non sapevo neppure accendere il computer; in futuro, se continuiamo a delegare in modo cieco e incoerente alle AI, i programmatori non sapranno più scrivere “Hello World”, sempre che questa cosa abbia ancora un senso.

Nel 2025 però osserviamo già i segnali di questa deriva: sviluppatori iniziano a sentirsi bloccati o lenti se non hanno a disposizione GitHub Copilot per un disservizio:

Copilot è down: andiamo a farci un caffèNon suona così strano, vero?

Superiamo la logica del Cubo Borg

L’analogia con i Borg ci offre un modo fuori dagli schemi per esaminare la nostra traiettoria tecnologica. Stiamo costruendo un sistema di potenza eccezionale, capace di svolgere compiti complessi con velocità superiore a quella di un uomo. Ad ora questi sistemi sono imperfetti, ma col tempo diventeranno sempre migliori ed efficienti.

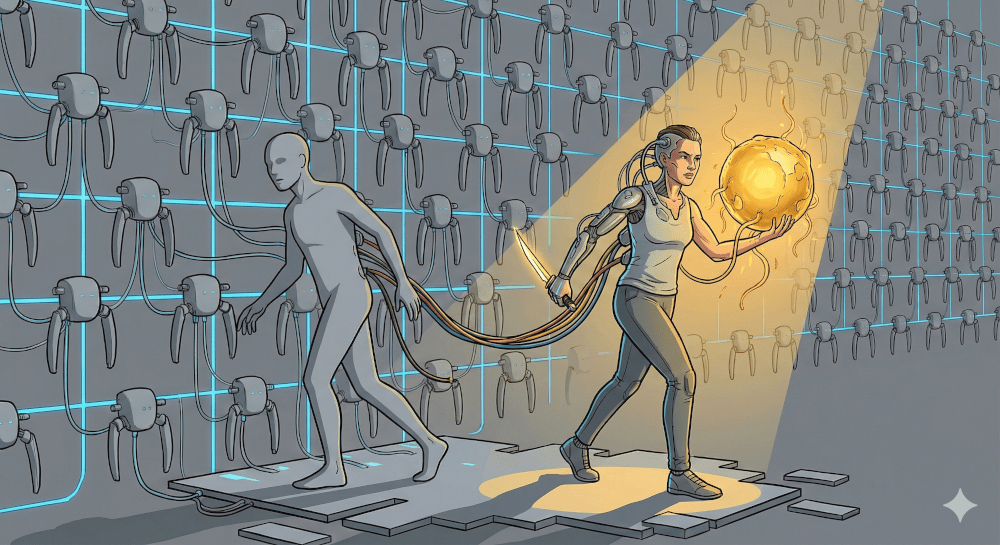

Qui sta il paradosso fondamentale: l’adozione dell’AI generativa è ormai inevitabile per chi vuole rimanere competitivo nel mercato del lavoro. La “resistenza” tradizionale è davvero inutile. Ma come la adottiamo non è predeterminato.

La vera scelta non è tra usare o non usare l’AI, ma tra integrazione consapevole e dipendenza passiva. Possiamo diventare come Sette di Nove, il personaggio di Star Trek che mantiene la propria identità pur avendo integrato tecnologia Borg, oppure possiamo essere semplici droni senza volontà critica.

Non perdiamo la pratica della programmazione, mantenendo una percentuale di sviluppo libera da aiuti dati dall’AI in modo da mantenere le capacità di problem solving.

Revisioniamo il codice comprendendone la logica: accettare una pull request che non manda in errore i test è una pratica non sufficiente per accettare del codice nel branch main.

Non leghiamoci a un solo prodotto, mischiando prodotti closed e open source: mettere in competizione più idee non può che far bene ai nostri progetti.

Se permettiamo ai modelli centralizzati di dettare non solo la sintassi, ma anche la logica e l’etica del nostro codice, rischiamo di svegliarci in un futuro in cui la programmazione è soltanto scrivere prompt sempre più banali, mentre l’AI sistema tutto per noi.

La vera resistenza non è rifiutare la tecnologia, ma rifiutare di diventare operatori acritici. In un mondo dove l’intelligenza artificiale pervade ogni aspetto dello sviluppo, la voce individuale dello sviluppatore, imperfetta ma capace di intuizione e creatività genuina, ha ancora un valore insostituibile.

I dati del 2025 ci dicono che l’assimilazione è già in atto. La domanda non è più se diventeremo ibridi umano-AI, ma come lo diventeremo mantenendo intatta la nostra capacità critica.

La storia dei Borg ci insegna che un collettivo può essere perfetto, ma è anche terribilmente silenzioso e nel silenzio l’innovazione muore.