L’inefficienza nascosta di JSON nell’era dell’AI

Nel mondo dello sviluppo software, JSON è il re indiscusso. È leggibile, strutturato, universale. Ma ecco la verità scomoda che nessuno ti ha detto quando hai iniziato a costruire con l’AI: agli LLM non importa quanto sia “puro” il tuo formato dati. A loro importano i token.

Se continui a inviare e ricevere grandi blocchi JSON a modelli come GPT-4, Claude 3.5 o Llama 3, stai letteralmente bruciando risorse: bandwidth semantico, latenza e soprattutto budget.

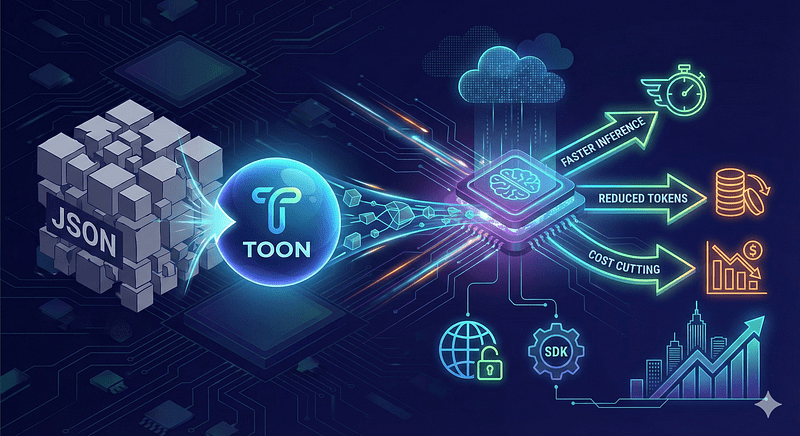

Entra in scena TOON

Recentemente è stato lanciato TOON (Token-Oriented Object Notation), e l’industria ne sta parlando molto. TOON sostituisce JSON nei prompt e nei payload per LLM, riducendo token, accelerando l’inferenza e tagliando i costi. La specifica e l’SDK sono pubblicamente disponibili e mostrano miglioramenti concreti per la produzione.

TOON non è un semplice trucco di sintassi: è una rappresentazione progettata specificamente per minimizzare i token ridondanti mantenendo leggibilità umana e compatibilità con schemi e validazioni.

Il problema: il “costo di sintassi” di JSON

Per capire perché JSON è inefficiente per l’AI, dobbiamo capire come “leggono” i modelli: attraverso la tokenizzazione.

Gli LLM usano tokenizzatori come BPE (Byte Pair Encoding). Ogni carattere conta, ma JSON è pieno di caratteri che sono “veleno” per l’efficienza dei token:

- Virgolette doppie (“”): ripetute migliaia di volte per chiavi e valori

- Parentesi graffe e quadre ({}, []): struttura rigida e verbose

- Spazi bianchi e a capo: formattazione visiva che consuma contesto prezioso

In un prompt medio di RAG (Retrieval-Augmented Generation), la sintassi JSON può occupare tra il 15% e il 25% dei tuoi token totali. Questo significa che un quarto della tua context window non viene usata per ragionamento o dati utili.

Cosa rende TOON diverso?

Eliminazione della ridondanza: TOON elimina le virgolette dalle chiavi e utilizza delimitatori che di solito sono token unici nei vocabolari dei modelli (come | o indentazione minima).

Compressione degli array: invece di ripetere strutture, utilizza definizioni di schema implicite che l’LLM comprende naturalmente.

Token-friendly: è progettato per allinearsi a come i tokenizzatori BPE raggruppano le parole.

Esempio pratico: stesso dato, metà token

Prendiamo un semplice oggetto utente.

Approccio JSON classico:

json

[

{

"id": 101,

"nome": "Marco Rossi",

"ruolo": "admin",

"attivo": true

},

{

"id": 102,

"nome": "Laura Bianchi",

"ruolo": "user",

"attivo": false

}

]Code language: JSON / JSON with Comments (json)Consumo approssimativo: ~55 token

Approccio TOON:

#User|id,nome,ruolo,attivo

101|Marco Rossi|admin|T

102|Laura Bianchi|user|FCode language: PHP (php)Consumo approssimativo: ~25 token

Risultato: riduzione del 54% nell’uso dei token per la stessa identica informazione.

L’impatto reale su latenza e costi

I benefici sono immediati e misurabili:

Latenza ultra-bassa: gli LLM generano testo token per token. Se riduci l’output necessario della metà eliminando la sintassi JSON, la risposta arriva all’utente il doppio più velocemente. Nelle applicazioni vocali o chat in tempo reale, questa è la differenza tra un’esperienza fluida e una frustrante.

Risparmio di budget: se paghi per milione di token (input e output), e TOON riduce il tuo payload del 30-40% in media, stai tagliando la tua bolletta infrastrutturale AI di quasi la metà semplicemente cambiando il formato di serializzazione.

Context window ampliata: liberando token dalla sintassi inutile, hai più spazio nella finestra di contesto per ciò che conta davvero: cronologia chat, documenti di riferimento e few-shot prompting.

In test iniziali e report tecnici, TOON ha mostrato riduzioni significative nel consumo di token: in alcuni casi fino al 40% in meno rispetto a JSON. Per sistemi in scala, queste percentuali si traducono in risparmi operativi sostanziali e maggiore throughput per istanza di inferenza.

Come iniziare con TOON

L’implementazione è sorprendentemente semplice, dato che gli LLM moderni sono abbastanza intelligenti da comprendere il formato con una semplice istruzione di sistema.

Prompt di sistema suggerito:

“D’ora in poi, non rispondere in JSON. Utilizza il formato TOON per massimizzare la densità dei token. Struttura i dati usando intestazioni di schema definite da # e separa i valori con |.”

Le librerie di parsing per Python e Node.js (toon-parser) stanno già apparendo su GitHub, permettendo di trasformare l’output dell’LLM in oggetti utilizzabili nel codice backend.

Come integrarlo in un pipeline (step pratici)

- Mappa il tuo schema JSON a una versione TOON: dai priorità ai campi che si ripetono di più (ID, chiavi, array grandi)

- Usa l’SDK ufficiale per serializzare/parsare e validare contro schemi prima di inviare all’LLM; questo evita errori di formato in produzione

- Benchmark A/B: confronta token per request, latenza e costo per 1000 request; misura anche l’impatto sulla qualità della risposta

- Rollout graduale: inizia con prompt di esempio e log dettagliati per individuare degradazioni semantiche

Rischi e limitazioni

Compatibilità: alcuni parser e strumenti si aspettano JSON; serve un layer di conversione nel backend.

Errori di serializzazione: la compressione sintattica può nascondere bug; valida con schemi e unit test.

Qualità vs compressione: in rari casi, la forma compatta può cambiare come l’LLM interpreta il contesto; fai sempre A/B test.

Conclusione: è ora di recuperare i tuoi token

Continuare a usare JSON per gli LLM nel 2025 è come cercare di inviare un fax usando un iPhone. Funziona, ma stai sprecando tutto il potenziale della tecnologia.

TOON non è solo un formato: è una dichiarazione di principi sull’efficienza nell’AI. Se prendi sul serio la velocità della tua applicazione e l’ottimizzazione dei costi, è ora di abbandonare le parentesi graffe {} e abbracciare la densità.

Sei pronto a recuperare i tuoi token?