Nel panorama dell’intelligenza artificiale contemporanea, gli MCP Server (Model Context Protocol Server) emergono come una tecnologia cruciale per connettere i modelli di AI con servizi e dati esterni. Questa innovazione è nata dalla necessità di andare oltre le limitazioni dei modelli linguistici convenzionali, che si basano su informazioni statiche, permettendo invece un’interazione dinamica con strumenti, API e fonti di dati del mondo reale.

Un MCP Server (Model Context Protocol Server) si configura come un servizio API standardizzato che svolge un ruolo di intermediario critico tra gli agenti di Intelligenza Artificiale (AI) e le risorse esterne necessarie per eseguire compiti reali.

La sua missione principale è fungere da traduttore e orchestratore. Traduce le intenzioni espresse dall’agente in linguaggio naturale (come un comando o una richiesta) in operazioni effettive e strutturate. Di fatto, gestisce l’intera orchestrazione delle chiamate a servizi esterni, database e vari strumenti.

Funzioni Operative Principali

In concreto, un MCP Server svolge diverse attività fondamentali per il funzionamento di un ecosistema AI:

- Accessibilità delle Risorse: Rende accessibili risorse e strumenti eterogenei agli agenti AI sotto forma di endpoint standardizzati. Questo significa che l’agente non deve preoccuparsi dei dettagli tecnici di ciascuna risorsa, ma interagisce con un’unica interfaccia.

- Gestione dello Stato e del Contesto: Amministra lo stato e il contesto delle interazioni in corso. Questo è cruciale per le conversazioni e le sequenze di operazioni complesse, garantendo che l’agente “ricordi” i passi precedenti.

- Garanzia Operativa: Assicura performance, sicurezza e conformità normativa durante tutte le operazioni, fungendo da strato protettivo e ottimizzatore.

Architettura e Caratteristiche Distintive

L’architettura di un MCP Server è costruita su livelli modulari progettati per garantire funzionalità avanzate, sicurezza e scalabilità.

Gli elementi chiave della sua architettura includono:

- Protocollo e Comunicazione: L’intera comunicazione si basa sul Model Context Protocol, un protocollo specifico che assicura che le interazioni siano sicure e uniformi, indipendentemente dall’agente o dalla risorsa.

- Gestione degli Strumenti: Offre una funzionalità che consente agli agenti di scoprire e interrogare facilmente le risorse remote disponibili, trasformando la loro interazione in un processo fluido.

- Sicurezza Avanzata: Incorpora meccanismi di controllo rigorosi, essenziali non solo per la protezione dei dati, ma anche per prevenire i cosiddetti “exploit semantici”, ovvero tentativi di manipolare il comportamento del modello attraverso prompt ingannevoli.

- Capacità di Scala: Il server è progettato per supportare carichi di lavoro elevati e gestire in modo efficiente l’orchestrazione simultanea di più modelli e interazioni complesse.

Le caratteristiche che definiscono l’utilità e l’efficacia degli MCP Server sono:

| Caratteristica | Descrizione |

| Uniformità | Offre un’interfaccia standardizzata (API) che può essere utilizzata in modo coerente da diversi modelli di intelligenza artificiale, riducendo la complessità di integrazione. |

| Espandibilità | Supporta l’integrazione di plugin e personalizzazioni (custom integrations), consentendo agli sviluppatori di aggiungere nuove risorse o funzionalità secondo necessità. |

| Memoria Contestuale | Mantiene attivamente traccia dello stato delle operazioni e del contesto delle conversazioni in corso, garantendo la continuità e la coerenza delle interazioni nel tempo. |

Il motore dietro la nascita del MCP: Dal deterministico al semantico

L’esigenza di sviluppare il Model Context Protocol (MCP) è sorta come risposta diretta alle limitazioni strutturali delle precedenti architetture di integrazione AI. Storicamente, l’interazione tra i modelli di intelligenza artificiale e i sistemi esterni si basava su flussi deterministici e API rigide, un approccio che si è rivelato insostenibile con l’emergere di agenti AI sempre più autonomi.

Questi vecchi sistemi, spesso hardcoded, richiedevano agli sviluppatori di mappare ogni possibile azione dell’AI a una chiamata API specifica, rendendo il sistema fragile, difficile da scalare e incapace di gestire l’ambiguità tipica del linguaggio umano.

Con l’evoluzione verso agenti AI autonomi capaci di pianificare, ragionare e correggere il tiro in tempo reale mediante il linguaggio naturale, è diventato essenziale un protocollo che superasse questi vincoli, concentrandosi sui seguenti punti cardine:

1. Astrazione a un livello superiore: Il passaggio all’intento semantico

Il bisogno primario era quello di spostare il focus dai parametri tecnici statici a obiettivi di tipo semantico.

- Dal Procedurale al Dichiarativo: Nei sistemi tradizionali, l’agente doveva specificare come eseguire un compito (es. chiamare la funzione X con questi parametri precisi). Con il MCP, l’agente si concentra sul cosa deve essere raggiunto (es. “Ho bisogno di trovare un’ora libera per la riunione di domani con Marco”).

- Inferenza e Traduzione: L’MCP Server non è solo un proxy, ma un motore di inferenza che traduce l’intento semantico espresso in linguaggio naturale in una sequenza validata di chiamate API tecniche. L’agente AI viene così astratto dalla complessità delle specifiche API sottostanti (formati, endpoint, schemi di autenticazione).

- Gestione del Contesto Dimenticato: Questa astrazione permette al modello di operare su un piano di ragionamento elevato, delegando al protocollo la gestione dei dettagli esecutivi, essenziali ma ingombranti.

2. Orchestrazione flessibile: La pianificazione dinamica delle azioni

I compiti complessi nel mondo reale raramente si riducono a una singola chiamata API. Richiedono l’esecuzione concatenata e sequenziale di diversi strumenti e risorse in un flusso logico.

- Superare i flussi predefiniti: Le vecchie integrazioni fallivano nel momento in cui un agente doveva deviare da un workflow predefinito. L’MCP, invece, supporta una pianificazione dinamica e on-the-fly.

- Chain of Thought (CoT) nell’esecuzione: Consente all’agente di eseguire una vera e propria “catena di pensiero” che si traduce in una “catena di esecuzione” (ad esempio: Passo 1: Cerca disponibilità sul calendario → Passo 2: Se non disponibile, cerca email recenti → Passo 3: Genera una risposta di scusa). Il protocollo gestisce lo stato intermedio di questa catena per garantire la coerenza.

- Tolleranza al fallimento: Una volta avviata una sequenza complessa, l’MCP può essere progettato per gestire in modo robusto i fallimenti a metà strada, consentendo all’agente di identificare l’errore e ritentare con un approccio diverso, senza far collassare l’intero sistema.

3. Interfaccia Intuitiva: L’Interazione nativa per i LLM

Per sfruttare appieno la potenza dei Large Language Models (LLM), è necessario un meccanismo di interazione che sia nativo al loro funzionamento. Le API tradizionali si aspettano un payload di dati strutturati (es. JSON o XML) con un preciso schema sintattico, i modelli linguistici sono invece eccellenti nel generare e interpretare il linguaggio naturale e le descrizioni discorsive.

L’MCP sostituisce l’obbligo di fornire dati strutturati con la possibilità di utilizzare descrizioni e prompt in linguaggio naturale come input primario per l’azione, l’agente non deve formattare i dati, ma descrivere l’azione. Questo approccio non solo potenzia l’autonomia dell’agente, ma semplifica anche la vita agli sviluppatori, che possono definire le capacità degli strumenti attraverso semplici schemi o descrizioni testuali, lasciando al MCP il compito di convertire l’intento in chiamata tecnica (o viceversa, interpretare la risposta tecnica per l’AI).

Da microservizi a risorse AI

Avendo un catalogo di microservizi REST, ognuno con una funzione specifica, è possibile trasformarli in tools MCP, in modo da essere utilizzati da agenti AI o chatbot per mezzo di un protocollo standard.

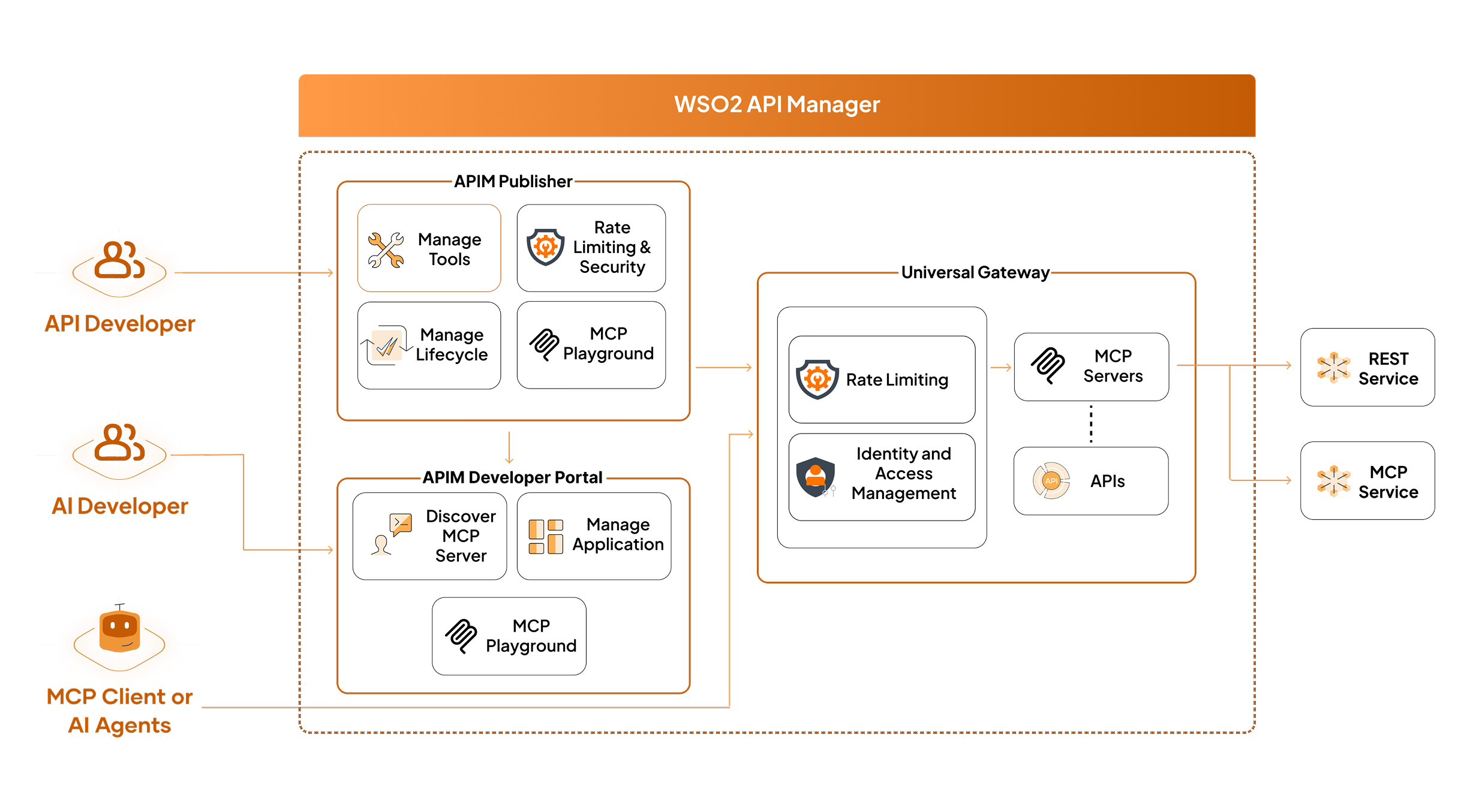

WSO2 API Manager dalla versione 4.6 integra nativamente questo processo permettendo la governance delle API esposte, i criteri di sicurezza ed il monitoraggio come già implementato per le API tradizionali.

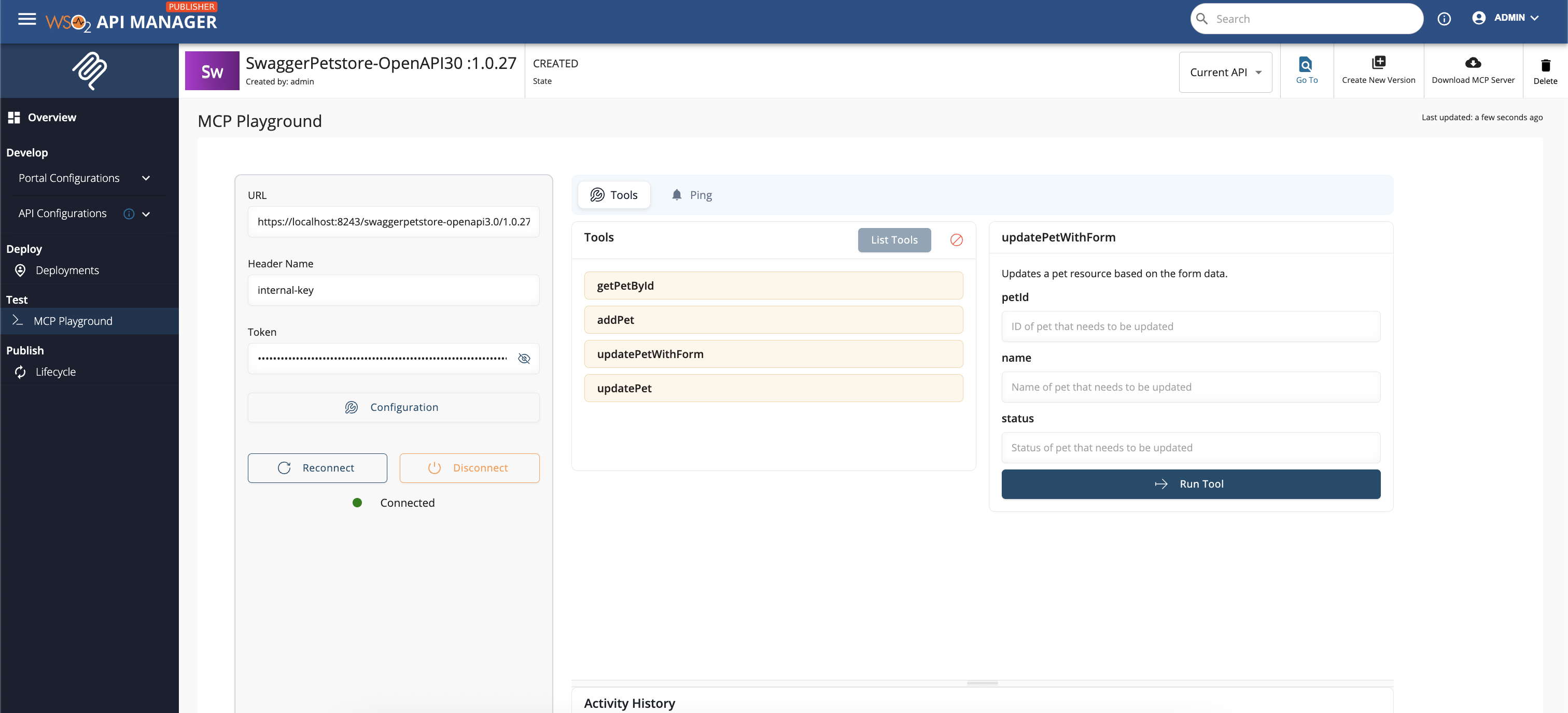

Il processo di pubblicazione inizia nel Publisher (interfaccia esposta dal Control Plane di WSO2 API Manager), qui è possibile importare la definizione OpenAPI del microservizio o selezionare un’API già pubblicata. WSO2 mette a disposizione un wizard per generare un server MCP che traduce le operazioni del microservizio in tool MCP. Ogni tool è definito con input ed output tipizzati, pronti per essere invocati da un client MCP

In questa fase è possibile personalizzare nomi, descrizioni e schemi in modo da rendere i tools più intuitivi ed aderenti agli standard aziendali. Migliorare la descrizione aiuta l’agente AI a scegliere ed utilizzare in maniera corretta il singolo tool.

Una volta terminata la configurazione del server MCP si procede con la pubblicazione e quindi la distribuzione sui Gateway (Universal GW, Kubernetes o Immutable). Il Gateway provvede ad esporre il protocollo MCP tramite HTTP streamable, pronto per essere consumato dagli agenti AI. Il client MCP è in grado di scoprire i tools disponibili, leggere gli schemi definiti in modo da invocare in maniera corretta ogni tool. Il Gateway applica anche le policy di sicurezza ed si occupa di instradare le richieste verso il microservizio.

MCP a portata di mano

Con il supporto MCP, WSO2 API Manager non si limita a gestire API: le trasforma in strumenti intelligenti, pronti per essere utilizzati da agenti AI. Il risultato è un ecosistema in cui i microservizi non sono solo endpoint, ma componenti attivi di flussi cognitivi, governati con sicurezza, versioning e monitoraggio.