L’intelligenza artificiale non ti ascolta più. Ti sostituisce.

O almeno, ci prova. Perché quello a cui stiamo assistendo non è l’ennesima evoluzione incrementale dei chatbot. È un cambio di paradigma radicale: stiamo passando dall’era del “chiedere risposte” all’era del “delegare il lavoro”. E questo cambia tutto.

Fino a ieri, il modello mentale era semplice: scrivi un prompt, il modello ti restituisce del testo, fine. Se il prompt faceva schifo, il risultato faceva schifo. Tutta la responsabilità stava nella tua capacità di formulare l’istruzione perfetta.

Oggi, gli agenti IA non aspettano passivamente le tue istruzioni. Hanno un obiettivo, percepiscono l’ambiente, ragionano, usano strumenti e si adattano quando falliscono. Non sono più assistenti. Sono esecutori autonomi.

Dal chatbot all’agente: cosa è davvero cambiato

La differenza fondamentale sta nel loop decisionale. Un chatbot risponde. Un agente persegue.

Facciamo un esempio concreto. Se chiedi a ChatGPT “Analizza le tendenze IA del 2026”, otterrai una risposta basata sui suoi dati di training. Punto.

Un agente IA con lo stesso obiettivo:

- Cerca informazioni aggiornate sul web

- Identifica le fonti più autorevoli

- Estrae i pattern ricorrenti

- Incrocia i dati con database interni

- Genera un report strutturato

- Se qualcosa non torna, ripete il processo affinando la ricerca

Tutto questo senza che tu debba scrivere una singola istruzione aggiuntiva dopo quella iniziale.

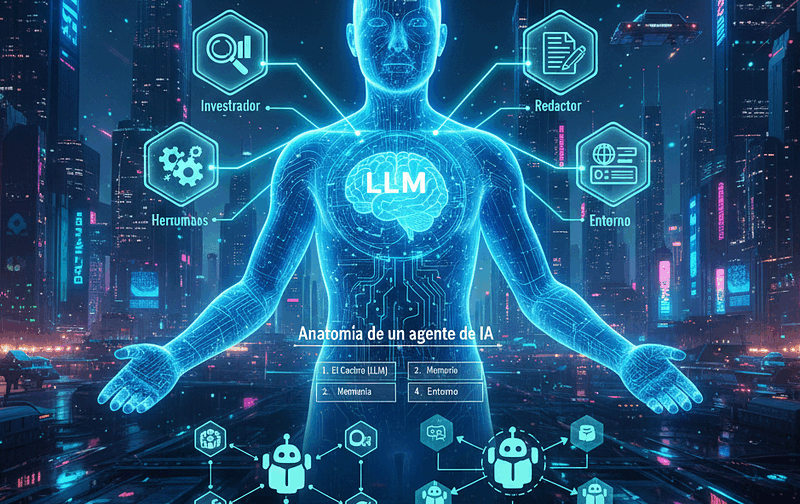

Anatomia di un agente IA: i quattro pilastri

Per capire come funziona tecnicamente un agente, pensalo come un organismo composto da quattro elementi fondamentali:

1. Il cervello (LLM)

È il motore di ragionamento. Modelli come GPT-4o, Claude 3.5 o Gemini agiscono come il motore base dell’agente. Processano il linguaggio naturale, pianificano i passi successivi e orchestrano l’uso degli strumenti.

2. La memoria

Fornisce contesto a breve e lungo termine. L’agente ricorda i passaggi precedenti, cosa ha funzionato, cosa ha fallito. Senza memoria, ogni azione è scollegata dalla precedente. Con la memoria, l’agente impara dal proprio comportamento.

3. Gli strumenti (tools)

Sono la capacità di uscire dal modello. Un agente può invocare API, cercare sul web, eseguire codice, accedere a database, controllare un browser. Gli strumenti sono ciò che trasforma un LLM da “generatore di testo” a “esecutore di azioni”.

4. L’ambiente

È lo spazio digitale dove avviene l’azione: un browser, un terminale, un database, un’interfaccia grafica. L’agente non vive nel vuoto, interagisce con sistemi reali.

Esempio pratico: costruire un agente di ricerca

Vediamo come si traduce tutto questo in codice utilizzando framework moderni come LangChain o CrewAI.

Setup base con LangChain

Per prima cosa, installa le dipendenze necessarie:

pip install langgraph langchain-openai langchain-community python-dotenv tavily-python

Poi definiamo l’agente vero e proprio:

import os

from dotenv import load_dotenv

from langchain_openai import ChatOpenAI

from langchain.tools import tool

from langchain_community.tools import TavilySearchResults

from langgraph.prebuilt import create_react_agent

# Configurazione

load_dotenv()

llm = ChatOpenAI(model="gpt-4o", temperature=0)

# Strumento di ricerca web

search_tool = TavilySearchResults(max_results=5, include_answer=True)

# Strumento personalizzato per analisi

@tool

def analyze_data(topic: str) -> str:

"""Analizza dati su un tema specifico."""

return f"Analisi completata per: {topic}"

# Creiamo l'agente

agent = create_react_agent(

model=llm,

tools=[search_tool, analyze_data],

prompt="Sei un assistente IA. Usa gli strumenti per investigare."

)

# Esecuzione

result = agent.invoke({

"messages": [{

"role": "user",

"content": "Analizza le tendenze IA del 2026 e genera un report"

}]

})

print(result["messages"][-1].content)

Code language: PHP (php)Cosa succede qui?

L’agente riceve l’obiettivo, decide autonomamente di usare lo strumento di ricerca web, recupera informazioni aggiornate, le processa con lo strumento di analisi e genera il report finale. Tu non hai scritto la sequenza di azioni. L’agente l’ha decisa da solo.

La scala dell’autonomia: quando usare cosa

Non tutti i problemi richiedono un agente autonomo. Esiste una matrice decisionale che aiuta a scegliere l’approccio giusto:

| Tipo | Quando usarlo | Esempio |

|---|---|---|

| Automazione classica | Compiti ripetitivi e prevedibili | Report giornalieri automatici |

| Workflow con IA | Processi strutturati con input flessibili | Processare fatture in formati diversi |

| Agenti autonomi | Compiti complessi, non deterministici | Pianificare un viaggio completo |

Architetture: lupo solitario o squadra?

Esistono due modi principali di progettare sistemi agentici:

Agente singolo (single agent)

Un cervello centralizzato connesso a molti strumenti. Ideale per task sequenziali rapidi. Il limite? Può confondersi se ha troppe opzioni a disposizione.

Sistema multi-agente

Un ecosistema di agenti specializzati coordinati da un orchestratore. Ogni agente ha un ruolo specifico: ricercatore, redattore, revisore. Collaborano, si passano il lavoro, creano un conflitto costruttivo che migliora il risultato finale.

Esempio multi-agente con CrewAI

from crewai import Agent, Task, Crew

import os

os.environ["OPENAI_API_KEY"] = "la-tua-key"

# Definizione agenti specializzati

ricercatore = Agent(

role='Ricercatore IA',

goal='Analizzare trend IA 2026',

backstory='Esperto di intelligenza artificiale con 10 anni di esperienza',

verbose=True,

allow_delegation=False

)

redattore = Agent(

role='Technical Writer',

goal='Scrivere articoli tecnici chiari',

backstory='Traduce concetti complessi in storie comprensibili',

verbose=True,

allow_delegation=False

)

# Definizione task

compito = Task(

description="Genera un report su agenti autonomi IA per il 2026",

agent=ricercatore,

expected_output="Report in markdown di 500-800 parole"

)

# Creazione crew

squadra = Crew(

agents=[ricercatore, redattore],

tasks=[compito],

verbose=True

)

# Esecuzione

risultato = squadra.kickoff()

print(risultato)

Code language: PHP (php)Cosa cambia rispetto a prima?

Non hai un singolo agente che fa tutto. Hai specialisti che collaborano. Il ricercatore trova le informazioni, il redattore le trasforma in un articolo. Ognuno fa ciò per cui è stato ottimizzato.

LangChain vs CrewAI: quale scegliere?

Questa è la domanda che molti developer si fanno. La risposta dipende dal problema.

LangChain

- Filosofia: Framework generico per costruire catene di ragionamento

- Ideale per: Agenti singoli, task sequenziali, massima flessibilità

- Approccio: Tu costruisci il veicolo pezzo per pezzo

CrewAI

- Filosofia: Orchestrazione di squadre di agenti

- Ideale per: Sistemi multi-agente, problemi complessi che beneficiano di specializzazione

- Approccio: Definisci i ruoli, il framework gestisce la collaborazione

In pratica: se devi fare una ricerca web e generare un riassunto, usa LangChain. Se devi coordinare ricerca, scrittura, fact-checking e revisione, usa CrewAI.

Il nuovo ruolo umano: da produttore a supervisore

Questo cambio tecnologico trasforma radicalmente il nostro lavoro. Passiamo dal human-in-the-loop (esecuzione manuale) al human-on-the-loop (supervisione strategica).

Le nostre responsabilità diventano:

- Definire obiettivi strategici chiari

- Validare la qualità degli output

- Gestire le eccezioni etiche

- Fornire feedback per migliorare l’agente

Non produciamo più. Orchestriamo.

I problemi reali che nessuno ti racconta

Nonostante l’hype, i flussi agentici hanno limitazioni critiche:

1. Loop infiniti

L’agente può bloccarsi tentando di risolvere un passaggio senza successo. Senza timeout o meccanismi di fallback, continua all’infinito.

2. Allucinazioni a cascata

Un errore nel primo step si amplifica nei passaggi successivi. Se l’agente parte da un presupposto sbagliato, tutto ciò che costruisce sopra è compromesso.

3. Costi e latenza

Il ragionamento complesso (chain-of-thought) è computazionalmente costoso e lento. Un agente che fa 10 chiamate API per completare un task costa 10 volte di più di una singola chiamata.

4. Debugging complesso

Quando un agente sbaglia, capire dove e perché è molto più difficile rispetto a una funzione deterministica. Il comportamento emerge dalla combinazione di LLM, strumenti e ambiente.

Conclusione: il futuro non è il rimpiazzo totale

L’hype vorrebbe farci credere che gli agenti IA sostituiranno completamente gli esseri umani in compiti complessi. La realtà è più sfumata.

Il futuro probabile è un modello ibrido: squadre di agenti specializzati orchestrati da umani esperti. Gli agenti gestiscono l’esecuzione, gli umani definiscono strategia, validano risultati e gestiscono le zone grigie etiche.

Non si tratta di eliminare l’umano dal processo. Si tratta di elevarlo a un livello superiore di supervisione e decisione strategica.

E questo, per noi developer, significa una cosa: imparare a progettare sistemi che non si limitano a rispondere, ma che agiscono. Perché il codice che scriveremo domani non sarà più una sequenza di istruzioni deterministiche, ma un ecosistema di agenti che collaborano verso un obiettivo comune.

La domanda non è se questo accadrà. È se saremo pronti quando accadrà.